دعت دراسة بحثية جديدة ممولة من قبل وزارة الخارجية الأمريكية إلى فرض حظر مؤقت على إنشاء ذكاء اصطناعي متقدم يتجاوز قوة حاسوبية معينة، ويزعم مؤلفوها أن هذه التقنية تشكل “تهديدًا حقيقا يمكن أن يؤدي لانقراض الجنس البشري”.

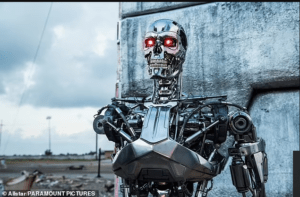

وتدعو الدراسة، التي تم التكليف بها كجزء من عقد فيدرالي بقيمة 250 ألف دولار، إلى “تحديد صلاحيات الطوارئ” للسلطة التنفيذية للحكومة الأمريكية “للرد على الحوادث الخطيرة المتعلقة بالذكاء الاصطناعي” على سبيل المقال ما يسمى “جيش الروبوتات”.

ودعت الدراسة إلى بعض الإجراءات الاحترازية والتدابير الأمنية لتحجيم خطر الذكاء الاصطناعي منها التعامل مع رقائق الكمبيوتر المتطورة باعتبارها سلعًا محظورة دوليًا، وحتى مراقبة كيفية استخدام الأجهزة.

وينضم التقرير إلى مجموعة واسعة من الأصوات الداعية لوقف تطوير أدوات الذكاء الاصطناعي من المجالات الصناعية والحكومية والأكاديمية التي تدعو إلى إيلاء اهتمام قوي بالأطر التنظيمية الحاكمة لإمكانات الذكاء الاصطناعي التي يتم متابعتها عن كثب والتي تغير قواعد اللعبة، ولكنها يمكن أن تكون مدمرة اجتماعيًا.

في يوليو الماضي، قامت وكالة الأمم المتحدة للعلوم والثقافة (اليونسكو)، على سبيل المثال، بربط مخاوفها المتعلقة بالذكاء الاصطناعي بشرائح الدماغ، على غرار شركة نيورالينك التي أنشأها إيلون ماسك، وحذرت من “المراقبة العصبية” التي تنتهك “الخصوصية العقلية”.

وبينما يشير التقرير الجديد في صفحته الأولى، إلى أن توصياته “لا تعكس آراء وزارة الخارجية الأمريكية أو حكومة الولايات المتحدة”، فإن مؤلفيه هم المسؤولين عن ملف الذكاء الاصطناعي داخل الحكومة الأمريكية منذ عام 2021.

قال مؤلفو الدراسة، وهي شركة استشارية للذكاء الاصطناعي مكونة من أربعة أشخاص تدعى شركة جلادستون للذكاء الاصطناعي ويديرها الأخوان جيريمي وإدوارد هاريس، لمجلة تايم إن عروضهم السابقة حول مخاطر الذكاء الاصطناعي كانت تُسمع في كثير من الأحيان من قبل المسؤولين الحكوميين الذين ليس لديهم سلطة التصرف.

وفي مقالة بحثية لـ “جلادستون” جاء فيها أن الذكاء الاصطناعي المتقدم والهجومي “يمكن استخدامه لتصميم وحتى تنفيذ هجمات بيولوجية أو كيميائية أو إلكترونية كارثية، أو تمكين تطبيقات مسلحة غير مسبوقة تستخدمها مجموعة من الروبوتات”.

لكن التقرير يطرح سيناريو ثانيًا أكثر بؤسًا، والذي يصفونه بأنه خطر “فقدان السيطرة” على الذكاء الاصطناعي.

وأضاف التقرير أن هناك “سببًا للاعتقاد بأن الذكاء الاصطناعي المسلح قد لا يمكن السيطرة عليه إذا تم تطويره باستخدام التقنيات الحالية، ويمكن أن يتصرف بشكل معاكس للبشر”.